- +1

超三千名海內外科技領袖聯名呼吁暫停開發(fā)“超級智能”

10月22日,中美兩國人工智能領域的頂尖專家和技術領袖聯名發(fā)起一項呼吁,在科學界達成“安全可控開發(fā)超級智能的廣泛共識”前,應暫停“超級智能”的研發(fā)。

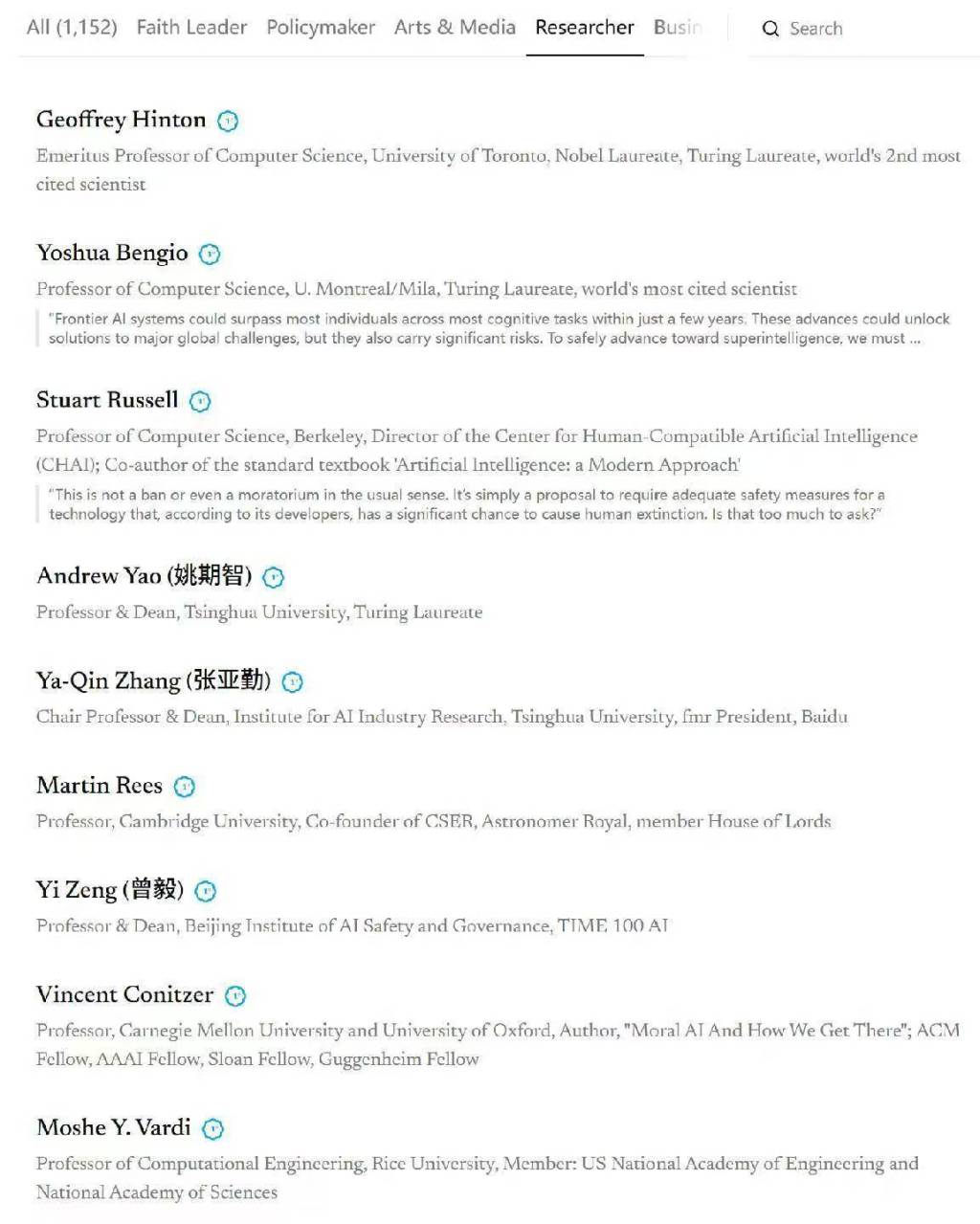

中外頂尖科技專家聯名簽署情況

該聲明由非營利組織未來生命研究所發(fā)起,包括人工智能先驅杰弗里·辛頓(Geoffrey Hinton)、蘋果公司聯合創(chuàng)始人史蒂夫·沃茲尼亞克(Steve Wozniak)、維珍集團董事長理查·布蘭森(Richard Branson)、經濟學家達龍·阿西莫格魯(Daron Acemoglu)以及前美國國家安全顧問蘇珊·賴斯(Susan Rice),都參與了簽名。

值得一提的是,哈里王子及其妻子梅根、薩塞克斯公爵和公爵夫人、史蒂夫·班農(Steve Bannon)和等知名人士也參與了聯合簽署聲明。

截至10月23日中午,這份聲明的簽署人數已經達3193人。中國科學院院士、圖靈獎得主姚期智、清華大學智能科學講席教授、智能產業(yè)研究院院長張亞勤,以及清華大學戰(zhàn)略與安全研究中心學術委員、蘇世民書院院長薛瀾等中國學者也位列其中。

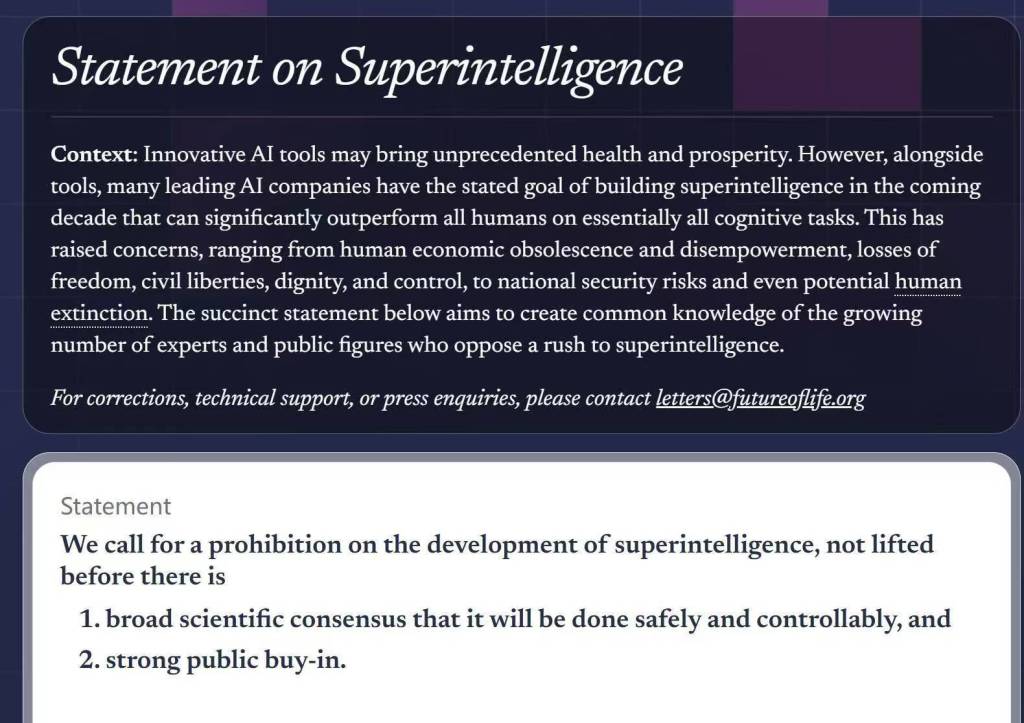

聲明 來源:官網截圖

“超級智能”是一種在所有認知任務上都超過人類的人工智能形式。有別于當下絕大多數公司研發(fā)通用人工智能,“超級智能”的前景引發(fā)業(yè)界擔憂。該聲明稱,許多頂尖AI企業(yè)將要打造超級智能,“引起了人們的擔憂,從人類經濟過時和被剝奪權力、自由、公民自由、尊嚴和控制的喪失,到國家安全風險,甚至潛在的人類滅絕。”

參與這一呼吁的北京前瞻人工智能安全與治理研究院院長,中國科學院自動化研究所研究員曾毅告訴澎湃科技(www.ditubang.cn),目前我們還沒有堅實的科學證據和切實可行的方法來確保超級智能的安全,使其不會給人類帶來災難性的風險。世界尚未準備好迎接不是可控工具的超級智能。

當前,超級智能已成為人工智能領域的熱門詞匯。從埃隆·馬斯克(Elon Musk)的xAI到薩姆·奧特曼(Sam Altman)的OpenAI等公司都在競相推出更先進的大語言模型。Meta甚至將其LLM部門命名為“Meta超級智能實驗室”。

科技界的人們對人工智能的看法越來越兩極分化:一方認為它是推動社會進步的強大力量,理應不受限制地發(fā)展;另一方則擔憂其潛在風險,主張加強監(jiān)管。

然而,即使是馬斯克和奧特曼等世界領先人工智能公司的領導人,過去也曾警告過超級智能的危險。在擔任OpenAI首席執(zhí)行官之前,奧特曼在2015年的一篇博客文章中寫道:“發(fā)展超人類機器智能(SMI)可能是對人類持續(xù)存在的最大威脅。”

曾毅認為,絕大多數公司研發(fā)的只是通用人工智能工具,這并不是超級智能。但是超級智能的風險是并沒有科學依據可以控制的。美國企業(yè),例如Meta建立超級智能實驗室,以及阿里聲稱的開發(fā)超級智能,這并不只是通用人工智能工具。

澎湃科技注意到,據《紐約時報》報道,10月22日聯合聲明發(fā)布當天,Meta在超級智能實驗室裁員 600人。該部門擁有約 3000 名員工,他們被授權開發(fā)“超級智能”,即超越人腦的人工智能。

Meta新任首席人工智能官亞歷山大·王 (Alexandr Wang)表示,裁員旨在清理因三年來過快建立Meta人工智能工作而導致的組織臃腫,從而幫助Meta更快地開發(fā)人工智能產品。Meta高管強調,裁員并不意味著他們正在縮減人工智能方面的工作,超級智能仍然是扎克伯格公司的首要任務之一。

- 報料熱線: 021-962866

- 報料郵箱: news@thepaper.cn

互聯網新聞信息服務許可證:31120170006

增值電信業(yè)務經營許可證:滬B2-2017116

? 2014-2025 上海東方報業(yè)有限公司