- +1

OpenAI又開源了:推出兩個能在筆記本和手機上運行的開源模型

當(dāng)?shù)貢r間8月5日,OpenAI推出自GPT-2以來的首批開源權(quán)重語言模型gpt-oss-120b與gpt-oss-20b,性能堪比o4-mini和o3-mini,可在高端筆記本和手機上運行。

OpenAI重新?lián)肀ч_源,該公司表示,發(fā)布開源系統(tǒng)的部分原因是,一些企業(yè)和個人更傾向于在自有計算機硬件上運行這類技術(shù)。“開源模型與我們的托管模型形成互補,為開發(fā)者提供了更豐富的工具選擇。”這有助于加速推進AI前沿研究,降低新興市場、資源受限行業(yè)及小型組織的使用門檻。

OpenAI總裁、創(chuàng)始人之一的格雷格·布羅克曼(Greg Brockman)說,“如果我們提供一款模型,人們就會用我們的技術(shù)。他們會依賴我們實現(xiàn)下一次突破。他們會給我們反饋、提供數(shù)據(jù),以及改進模型所需的各種信息。這有助于我們?nèi)〉眠M一步的進展。”

推出開源模型,可在手機運行

gpt-oss模型是OpenAI自2019年推出GPT-2以來發(fā)布的首批開源權(quán)重語言模型。OpenAI表示,gpt-oss-120b與gpt-oss-20b突破開源權(quán)重推理模型的邊界,在推理任務(wù)上的表現(xiàn)優(yōu)于同規(guī)模開源模型,能以低成本實現(xiàn)實際應(yīng)用性能,經(jīng)過優(yōu)化可在消費級硬件上高效部署。模型訓(xùn)練過程結(jié)合了強化學(xué)習(xí)技術(shù),并借鑒了OpenAI的o3和其他前沿內(nèi)部模型。

gpt-oss模型使用預(yù)訓(xùn)練和后訓(xùn)練技術(shù),注重推理能力、效率以及在各種部署環(huán)境中的實際可用性。每個模型都基于Transformer,利用混合專家(MoE)技術(shù)減少處理輸入所需的激活參數(shù)數(shù)量。gpt-oss-120b每token激活51億參數(shù),gpt-oss-20b每token激活36億參數(shù),兩款模型的總參數(shù)分別為1170億和210億。它們采用交替的密集型和局部帶狀稀疏注意力模式,類似于GPT-3。使用旋轉(zhuǎn)位置編碼(RoPE),支持長達(dá)128k上下文長度。兩款開源模型支持低、中、高三種推理強度,可在延遲和性能之間權(quán)衡,開發(fā)者只需在系統(tǒng)消息中用一句話就能設(shè)置推理強度。

OpenAI CEO山姆·奧特曼表示,gpt-oss的性能堪比o4-mini,而且能在高端筆記本上運行,更小的版本能在手機上運行。“不久的將來,會有一種比你認(rèn)識的最聰明的人還要智能的東西,在你口袋里的設(shè)備上運行,隨時隨地幫你解決各種問題。這真的是一件非同凡響的事。”

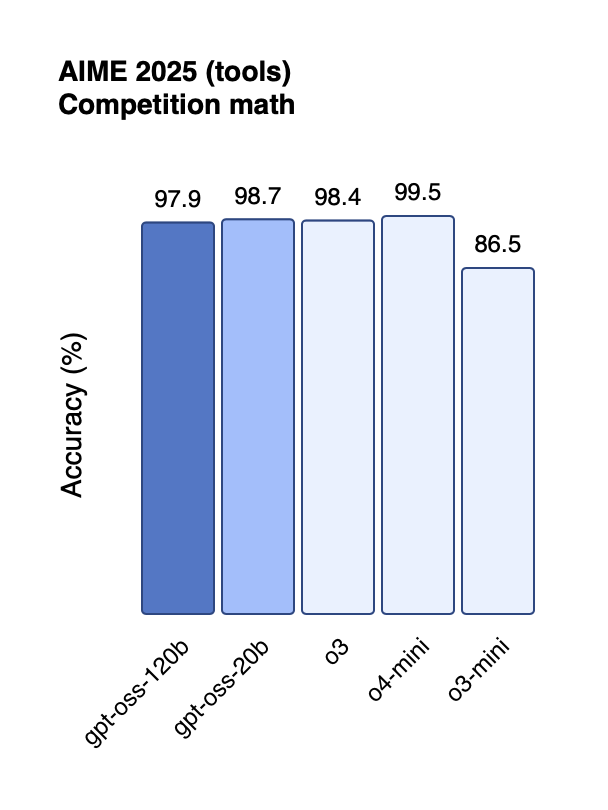

gpt-oss-120b與gpt-oss-20b在競賽數(shù)學(xué)方面的性能。

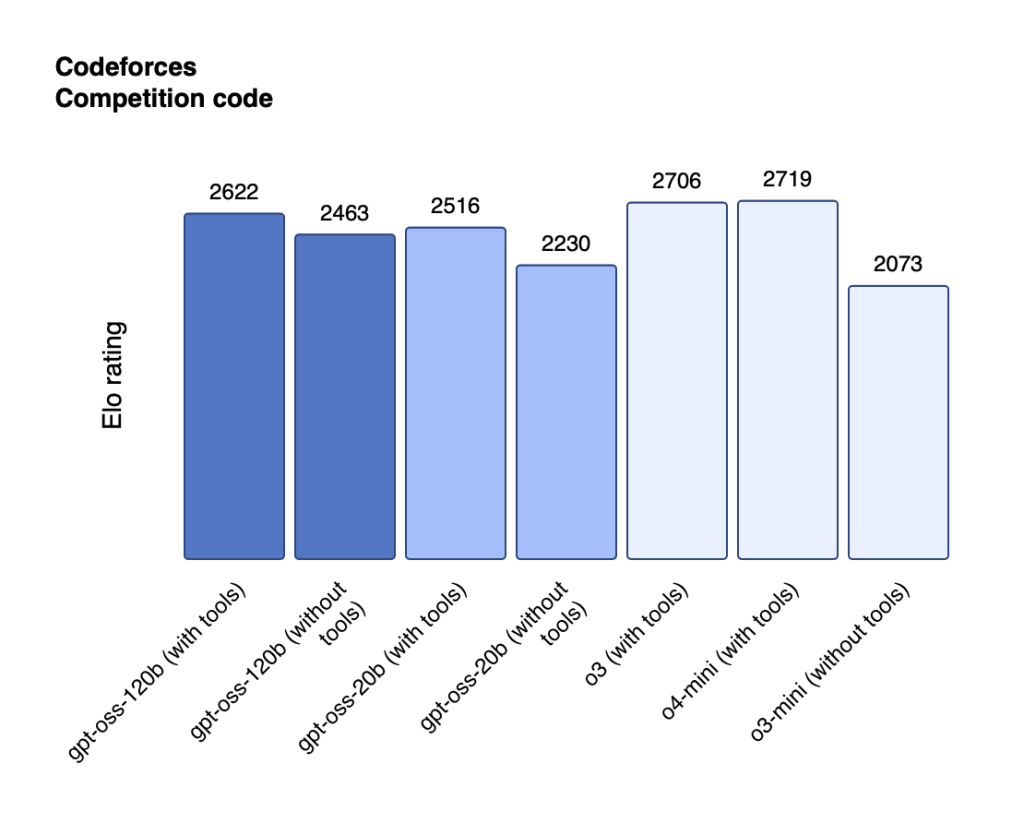

gpt-oss-120b與gpt-oss-20b在競賽編程方面的性能。

gpt-oss-120b模型在核心推理基準(zhǔn)測試上與OpenAI o4-mini幾乎持平,能在單張80GB GPU上高效運行。在競賽編程(Codeforces)、通用問題解決(MMLU和HLE)以及工具調(diào)用(TauBench)方面,gpt-oss-120b的表現(xiàn)優(yōu)于OpenAI o3-mini,達(dá)到或超過了OpenAI o4-mini。在健康相關(guān)查詢和競賽數(shù)學(xué)方面,它的表現(xiàn)甚至比o4-mini更好。gpt-oss-20b模型在常見基準(zhǔn)測試中的結(jié)果與OpenAI o3-mini相當(dāng),甚至在競賽數(shù)學(xué)和健康相關(guān)查詢方面的表現(xiàn)甚至超過了o3-mini,僅需16GB內(nèi)存即可在邊端設(shè)備上運行。

OpenAI為何重新?lián)肀ч_源

三年前,OpenAI推出ChatGPT并引發(fā)人工智能熱潮,其后,OpenAI的技術(shù)大多處于保密狀態(tài)。其他公司則通過“開源”共享技術(shù),搶占OpenAI的市場份額。尤其是DeepSeek的出現(xiàn),在全球范圍內(nèi)掀起了新的開源浪潮。如今,OpenAI重新?lián)肀ч_源,希望借此平衡競爭環(huán)境,確保企業(yè)和其他軟件開發(fā)者繼續(xù)使用其技術(shù)。OpenAI表示,發(fā)布開源系統(tǒng)的部分原因是,一些企業(yè)和個人更傾向于在自有計算機硬件上運行這類技術(shù)。

“開源模型與我們的托管模型形成互補,為開發(fā)者提供了更豐富的工具選擇。”O(jiān)penAI表示,這有助于加速推進前沿研究,迸發(fā)創(chuàng)新活力,在各類應(yīng)用場景中推動更安全透明的AI開發(fā)。這些開源模型還降低了新興市場、資源受限行業(yè)及小型組織的使用門檻。

近期的研究表明,只要模型未接受過針對思維鏈對齊的直接監(jiān)督訓(xùn)練,監(jiān)控推理模型的思維鏈就有助于檢測不當(dāng)行為。OpenAI表示,兩款gpt-oss模型的思維鏈均未接受任何直接監(jiān)督,而這對于監(jiān)控模型的不當(dāng)行為、欺騙性輸出和濫用風(fēng)險至關(guān)重要。發(fā)布兩款帶有非監(jiān)督式思維鏈的開源模型,能為開發(fā)者和研究人員提供機會,以便他們研究并構(gòu)建自己的思維鏈監(jiān)控系統(tǒng)。由于思維鏈可能包含幻覺信息或有害內(nèi)容,因此開發(fā)者不應(yīng)在其應(yīng)用中直接向用戶展示思維鏈內(nèi)容。

為了確保模型的安全性,在預(yù)訓(xùn)練階段,OpenAI過濾掉了與化學(xué)、生物、放射和核相關(guān)的特定有害數(shù)據(jù),在后訓(xùn)練中運用審慎對齊和指令層級技術(shù),教會模型拒絕不安全的提示詞,并防御提示詞注入攻擊。開源模型發(fā)布后,攻擊者可能會出于惡意目的對模型進行微調(diào)。為評估這類風(fēng)險,OpenAI針對特定的生物學(xué)和網(wǎng)絡(luò)安全數(shù)據(jù)對模型進行微調(diào),模擬攻擊者的方式,為每個領(lǐng)域創(chuàng)建了一個特定領(lǐng)域的 “不拒絕”版本,并通過內(nèi)外部測試評估這些模型的能力水平。測試表明,即便使用OpenAI行業(yè)領(lǐng)先的訓(xùn)練堆棧進行了微調(diào),這些經(jīng)過惡意微調(diào)的模型仍無法達(dá)到高能力水平。

OpenAI表示,這些流程標(biāo)志著開源模型的安全性邁出了有意義的一步,“我們希望這些模型能幫助推動整個行業(yè)的安全訓(xùn)練和對齊研究。”為構(gòu)建更安全的開源生態(tài)系統(tǒng),OpenAI發(fā)起獎金50萬美元的“紅隊挑戰(zhàn)”,鼓勵來自世界各地的研究人員、開發(fā)人員和愛好者幫助識別新的安全問題。

開源與閉源的辯論一直存在,企業(yè)的策略也在調(diào)整。與OpenAI擁抱開源不同,Meta或?qū)⑥D(zhuǎn)向更保守的閉源軟件策略。Meta新近成立超級智能實驗室后,實驗室一小批高級成員討論放棄該公司最強大的開源人工智能模型Behemoth,轉(zhuǎn)而開發(fā)閉源模型。

- 報料熱線: 021-962866

- 報料郵箱: news@thepaper.cn

互聯(lián)網(wǎng)新聞信息服務(wù)許可證:31120170006

增值電信業(yè)務(wù)經(jīng)營許可證:滬B2-2017116

? 2014-2025 上海東方報業(yè)有限公司