- +1

字節掀了大模型的桌子,火山引擎能彎道超車嗎?

文|白 鴿

編|王一粟

剛上AI大模型的牌桌,字節跳動就要掀桌子了。

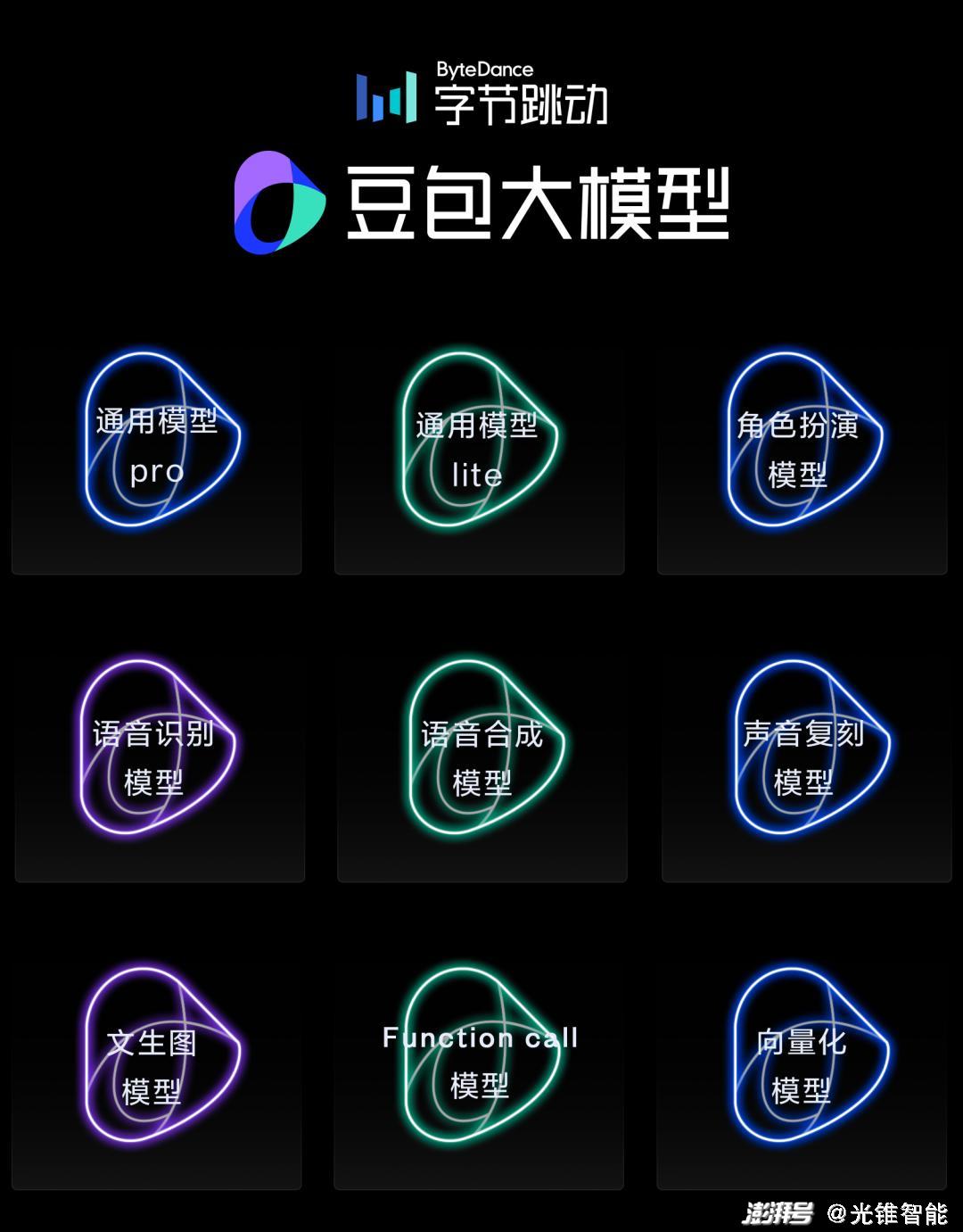

近日,字節跳動自研豆包大模型家族產品首次亮相,包括通用模型pro、通用模型lite、語音識別模型、語音合成模型、文生圖模型等九款模型。

“豆包家族”并不是第一次發布,而是整合升級了此前字節跳動的云雀大模型和一系列細分模型,統一為一個體系。

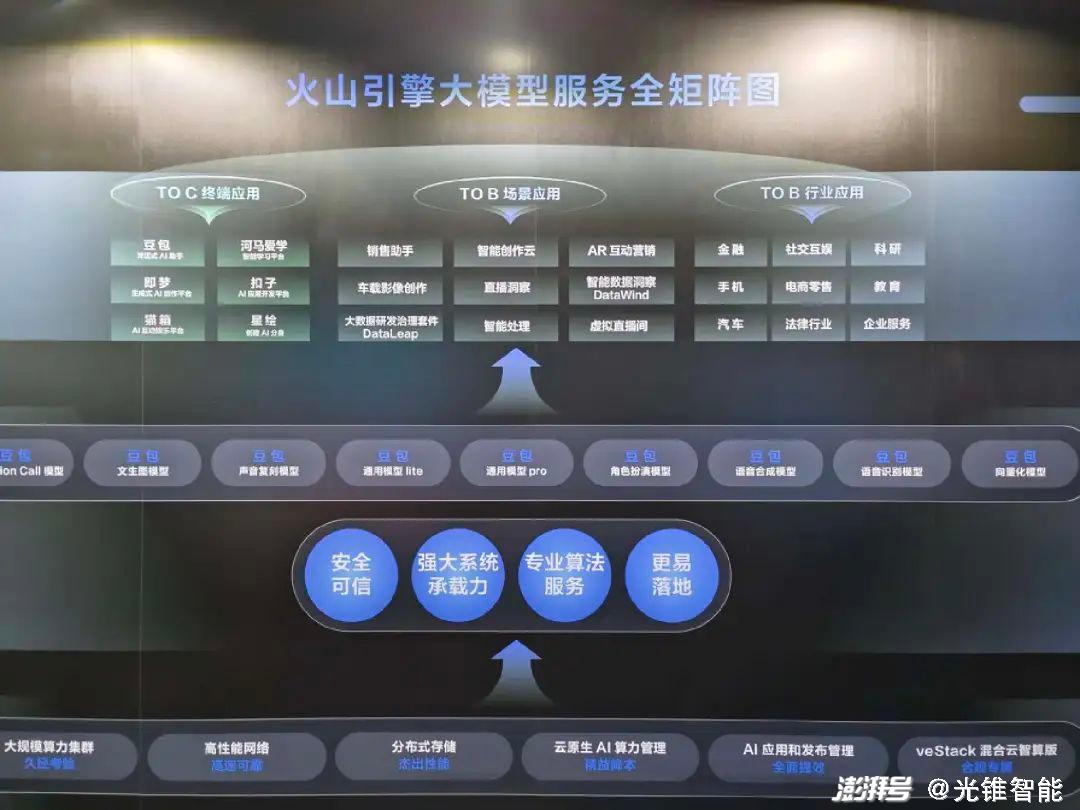

據了解,豆包家族將通過字節跳動云計算業務火山引擎正式“營業”,值得注意的是,在現場火山引擎的大模型服務全矩陣圖中,底層的大模型服務已經由此前的多個第三方大模型(MiniMax、百川等),全部替換為了豆包家族。

2024年大模型落地元年,大模型將在越來越多的企業場景中,從PoC(驗證性測試)走到真實的生產系統。

“不過,落地過程中,仍面臨著模型效果不夠好、推理成本高、落地應用難等挑戰。”火山引擎總裁譚待表示。

激烈的競爭和迫切的需求之下,各家大模型和云廠商都拿出了自己的殺手锏。

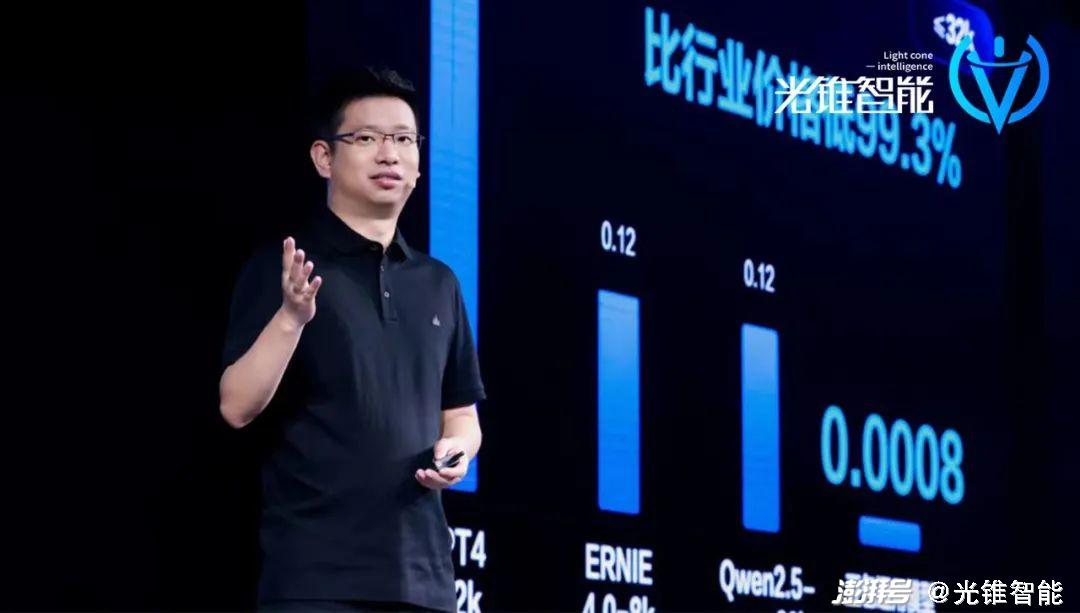

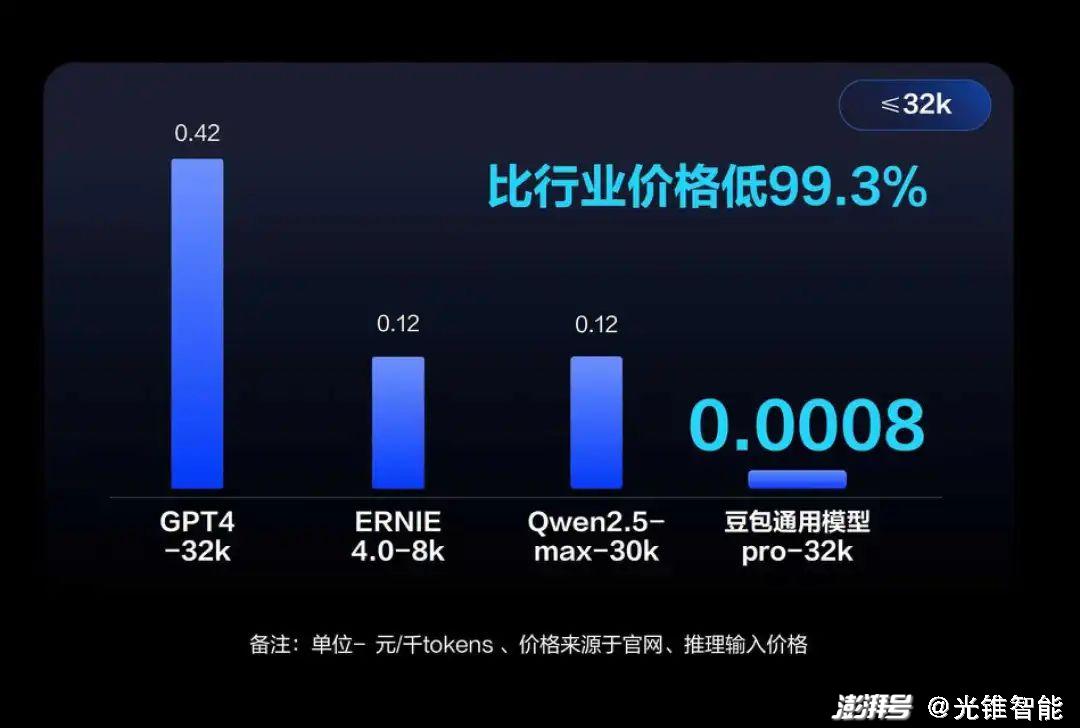

隨著豆包家族的就位,火山引擎也打出了一張自己的“殺手锏”——降價,將大模型的計價從以“分”計帶到以“厘”計的階段。

以豆包通用模型pro-32k版為例,模型推理輸入價格僅為0.0008元/千Tokens,而市面上同規格模型的定價一般為0.12元/千Tokens,是豆包模型價格的150倍。

也就是說,豆包通用模型比行業便宜99.3%。

據火山引擎公布的價格計算,一元錢就能買到豆包主力模型的125萬Tokens,大約是200萬個漢字,相當于三本《三國演義》。

譚待認為,降低成本是推動大模型快進到“價值創造階段”的一個關鍵因素。

事實上,在云計算領域,以價換規模,是近兩年來云廠商們的主流做法。

火山引擎作為云計算領域的后來者,從成立之初就一直致力于成為國內的第四朵云,但時至今日,火山引擎在云市場份額統計表中仍屬于Other。

現如今,在大模型剛剛落地應用初期,火山引擎就直接開“卷”價格戰,想要以大模型落地來搶占云計算市場份額。

就像譚待對光錐智能表示:“大模型尚未真正大規模落地,只要把價格降下來就還有機會。火山引擎最重要的,就是如何把最佳實踐做好、市場做大。”

豆包大模型,產品思維下的大模型矩陣

字節跳動產品和戰略副總裁朱駿

棒球帽、T恤和短褲,字節跳動產品和戰略副總裁朱駿的這身日常著裝,像是剛從公司開完上一個日常溝通會,就上了火山引擎的發布會。

他還用自己沒有西裝的梗,讓大模型做了一張宣傳照,批評現在大模型的華而不實。

朱駿的不拘一格,也是字節文化的體現,在拘謹的ToB賽道里格外顯眼。朱駿的實用主義和產品價值觀也在豆包家族上體現的淋漓盡致。

在朱俊看來,大模型不只是服務器上的一堆代碼,而是需要找到最適合的應用形態,以足夠自然的交互形式,才能夠讓更多用戶用起來。

相比于其他廠商,字節跳動做大模型的思路,是以做產品的思維,先推動豆包產品用戶規模的增長,從而帶動大模型能力的提升。

這個思路非常實際,近期一眾ToC的大模型應用,也都在瘋狂砸錢做增長。同時,在具體產品應用方向上,則更貼近用戶。

此前,字節跳動的通用大模型并不叫豆包,而是叫“云雀大模型”。去年,字節跳動內部準備開發大模型產品時,需要為產品取名,最終被命名為豆包。

朱俊現場講述了最后取名為豆包的三個原則:擬人化、離用戶近,以及個性化。

從改名這件小事,其實我們就能夠看出字節跳動在大模型落地過程中,現階段的主要打法之一,是基于大模型的能力,構建更像人,也更懂人的智能體,并使其成為人類的AI助手。

如北京一個五年級的小學生,通過火山引擎旗下的扣子開發平臺,開發出了一個青蛙外教智能體。現在,這個小朋友不僅自己使用青蛙外教學習英語,還分享給她的同學和朋友們一起使用。

去年,飛書也上線了基于豆包大模型開發的智能伙伴,目前每天都有大量的企業員工通過飛書的智能伙伴進行工作總結、會議紀要和知識輔助。

朱駿也表示:當前雖然技術在快速演化,但用戶核心的需求沒有改變,包括高效獲取信息、工作提效、自我表達、社交娛樂等等。

與此同時,為了滿足不同場景中對智能體的不同需求,此次豆包大模型是以家族矩陣式亮相,不同的大模型,可以滿足不同的場景需求。

豆包大模型有兩款通用大模型,其中豆包通用模型pro是主力模型,具備理解、生成、邏輯、記憶等強綜合能力,支持128k長文本精調,且支持問答、總結、分類、創作等豐富的場景。

在長文本理解的場景中,豆包可以總結分析上傳三篇論文中的亮點,還可以讓它觸及和論文相關的題目,來考察其是否對文檔、論文等有非常清楚的理解。

“豆包pro模型非常強大,但在有些場景里,用戶對延時和成本會非常敏感,這個時候,豆包通用模型lite是大家更好的選擇。”譚待如此說道。

豆包通用模型lite是更具性價比的通用模型,千Tokens成本降低84%,延遲降低50%,它支持閑聊、天氣及實時信息查詢、音樂視頻播放、導航等場景,效果領先傳統語音處理50%以上。

如智能汽車的座艙交互,就是一個非常適合lite模型的應用場景。通過豆包lite,汽車廠商可以在低延遲下實現對話,支持閑聊、搜索、娛樂、導航、車控等多個座艙智能助手場景,效果要比傳統語音處理高50%以上,讓汽車變得更“聰明”。

除了通用大模型外,火山引擎還發布豆包角色扮演模型、語音系列模型、文生圖模型、Function call模型、向量化模型等其他細分領域模型。

其中,角色扮演模型支持角色高度定制,能夠基于上下文感知自適應用戶扮演或陪伴需求,且具有強劇情推動能力,能夠持續引導聊天。

豆包語音系列模型中:

豆包語音識別模型具有高準確率和個性化特征,支持多語種識別;

豆包合成模型具有自然、多情緒和多演繹特征;

豆包聲音復刻模型支持5秒復刻,跨語種遷移,與原聲具有高相似度。

按照以往字節跳動產品發布的情況來看,基本都是已經在內部經過多個業務線進行測試,并已經相對成熟的產品,才會拿到市場中做泛化應用,如飛書、火山引擎。

字節跳動去年開始加速大模型的研發,譚待現場表示,過去一年中,字節內部50多個業務已大量使用豆包進行AI創新,包括抖音、頭條、番茄小說等多個產品。

同時基于豆包大模型打造的同名豆包APP,在蘋果APP Store和各大安卓應用市場,下載量一度在AIGC類應用中排名第一。

據朱駿透露,豆包上已有超過800萬個智能體被創建,月度活躍用戶達到2600萬。

同時,火山引擎也以邀測的方式,和不同行業的頭部客戶對基于豆包大模型進行深度共創,包括手機、汽車、金融、消費、互娛等等領域。

“好的技術,一定是在大規模應用,在不斷應用情況下不斷打磨才能形成的。大模型也一樣,只有在真實場景中落地,用的人越多,調用量越大,才能讓模型越來越好。”

官方數據顯示,經過一年時間的迭代和市場驗證,豆包大模型正成為國內使用量最大、應用場景最豐富的大模型之一,目前日均處理1200億Tokens文本,生成3000萬張圖片。

“這么大的使用量,這么多的場景,讓我們覺得一切已經就緒。” 譚待的這句話,無疑表露了字節跳動大模型要向企業端落地應用的決心。

除了價格,火山引擎還有什么牌?

豆包家族的首次亮相,可以看作是字節跳動大模型發展的轉折點,即經過內部AI產品賽馬之后,字節收攏了經過產品驗證的大模型能力,并通過與火山引擎的結合,開始全面做增長。

于火山引擎而言,相比較目前主流云廠商們來說,受制于字節本身大模型開發節奏問題,火山引擎在自研大模型的應用上的步伐,始終遲了一步。

遲來的開局,B端業務的“慢”特點,讓火山引擎沒辦法像短視頻一樣,快速實現彎道超車。但從豆包的能力,和火山引擎當前大模型落地的思路來看,其與行業頭部的差距,正不斷縮小。

“一定要降低門檻去做。”譚待對光錐智能說明了火山引擎推動大模型向B端落地應用的策略,降低門檻,不光是價格上的降低,更重要的是能夠大模型能夠更簡單快速的實現落地應用。

AI應用開發平臺“扣子”,是火山引擎加速大模型快速落地應用的關鍵抓手。目前主流云廠商和大模型企業,都在推AI應用開發平臺,比如阿里云的魔搭、百度的千帆等等。

扣子,也可以理解為是智能體定義平臺,無論是否有編程基礎,都可以在扣子上快速搭建基于大模型的各類Bot,并將Bot發布到各個社交平臺、通訊軟件或部署到網站等其他渠道。

此次大會上,火山引擎也發布了扣子專業版,相比于面向C端的扣子平臺,企業版會根據企業的需求,以扣子平臺為基礎做進一步封裝。

據介紹,扣子專業版會額外提供企業級SLA保障,并且還有很多高級特性,包括自定義精調模型、自定義算力單元等,能夠讓企業在應用扣子便利性的同時,也能夠保障它的高性能和它的定制化,讓企業能夠高效便捷地開發專屬智能體。

現場,扣子產品經理潘宇揚表示,目前扣子平臺已經有了海底撈、超猩猩、招商銀行、獵聘等多位B端客戶。而扣子之所以能夠被這些企業所應用,主要還在于基于C端積累的優勢,即使用門檻低,一句話或一張圖就可以組成一個Bot,并且這個Bot更了解用戶。

一方面,扣子平臺可以提供長期記憶、數據庫、文件盒子等功能,可以讓Bot記住用戶喜好,并做個性化推薦。另一方面,其可以提供插件、觸發器、知識庫等能力,可讓Bot不斷獲取新的信息,從而更了解用戶周邊世界。

“大模型的到來,讓開發變得更加簡單。通過AI原生開發平臺,我們有機會讓每個人、每家企業都成為AI的開發者。”譚待說道。

AI應用開發平臺和云底層基礎設施,要同步升級,火山引擎才能趕上大模型時代的快車。

自從去年發布MaaS服務平臺火山方舟以來,火山引擎就希望通過推動基礎設施的方式,加速大模型在行業的落地。

在豆包大模型亮相后,火山方舟也推出2.0版,發布了3個重要插件,包括聯網插件、大模型內容插件、知識庫插件等,幫助企業大模型實現應用落地。同時,方舟2.0還全面升級了系統承載能力、安全保護能力和算法服務能力。

借大模型,搶云計算市場

大模型帶來的全新AI時代,正在成為云計算市場中的最大變量。

自成立之初,火山引擎就一直希望成為國內“第四朵云”。火山引擎借大模型,能否實現彎道超車?

從戰略打法來看,火山引擎放出了三個大招:

第一就是低價。 于當下企業而言,算力成本、推理成本十分高昂,而做企業市場,企業的痛點就是第一驅動力,因此火山引擎以低價為引子,切入企業市場。

火山引擎直接將豆包大模型的價格低于行業99%。

不過,譚待也表示:“To B的業務要求長期的定力,用虧損換收入是不可持續的,未來我們也會持續通過技術降低成本以降低價格。”

低價是吸引企業客戶的一個手段,但并不能成為影響企業選擇火山引擎的唯一因素。

因此,火山引擎的第二個戰略打法,就是聚焦字節的核心產品生態資源上,以C2B的形式,更好的推動大模型在各行各業的落地應用。

本次會上,光錐智能發現火山引擎大模型服務全景圖,其大模型服務主要聚焦三類應用場景,包括ToC的終端應用、ToB的場景應用以及行業應用。

相比較其他云廠商來說,火山引擎在大模型領域的核心競爭優勢之一,是來自于字節系中抖音、今日頭條等搜索和內容的豐富生態資源,尤其是通過與抖音巨量引擎相結合,在數字營銷、AI銷售、文本/視頻等內容創造上,而這也是火山引擎在AI應用層為企業提供服務的關鍵。

其中,在ToB 場景應用上,火山引擎也推出具有字節特色的產品,即搭載豆包大模型的智能創作云2.0版本,這是一個批量生成視頻的智能SaaS平臺,主要幫助電商賣家批量生成商品素材。

通過大模型的支持,用戶只需要輸入簡單的營銷描述,智創云2.0就能生成視頻文案、腳本和相關素材,并通過模板與混剪能力的搭配,幫助客戶在電商、生活服務等場景快速創作營銷視頻。

另外,在面向ToC 的終端應用上,除了早就推出的豆包和扣子,也新加入了4個垂類領域的AI平臺,分別面向智能學習、生成式AI、AI互動娛樂和AI分身。這4個垂類領域,也跟字節的核心業務優勢息息相關。

C2B雖然能夠給火山引擎帶來一定的生態資源優勢,但對于云計算市場而言,更簡單粗暴且真正有用的策略,在于買卡賣算力。

據光錐智能了解到,受大模型浪潮影響,字節的云計算業務火山引擎的營收增長也比較可觀。得益于字節前期儲備了大量英偉達的GPU,很多大模型創業公司都愿意主動加入到火山引擎的生態中,從而拉動了火山引擎的增長。

同時,在底層基礎設施上,火山引擎也推出了針對大規模AI場景的混合云產品veStack智算版。

據介紹,veStack智算版提供了從IaaS到機器學習平臺全棧的智算解決方案,可支持萬卡集群、3.2T高性能無損網絡;并且能提供端到端工程優化的97.78%訓練加速比,分鐘級故障發現和自愈恢復;支持十余種主流GPU卡的主流型號,能夠去兼容各種各樣的異構算力。

通過veStack智算版,企業能夠非常容易地搭建超高穩定性、超高效率的AI基礎設施,能夠大幅提升自己的算力效率,能夠輕松地實現對萬卡集群的管理。

不過,雖然第一波先靠賣算力賺到第一桶金,但對火山引擎來說,未來靠使用這些大模型公司的算法而再次為云計算業務付費的客戶,才是更吸引人的。

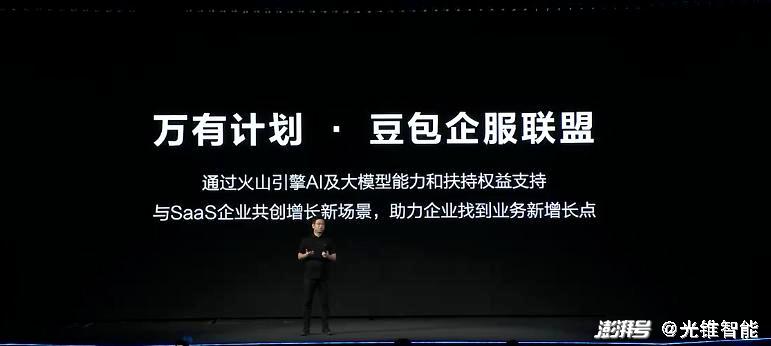

同時,于云廠商們來說,生態聯合會比單打獨斗更能夠為企業提供一體化服務,加強云廠商與企業之間的粘性。

因此,此次火山引擎也發布了“萬有計劃”——豆包企服聯盟,這是“萬有計劃”針對大模型應用的一個專項計劃,豆包企服聯盟將提供一攬子的支持措施,幫助SaaS企業實現自身的AI升級,最后這些SaaS企業與火山引擎一起為客戶提供更多開箱即用的AI應用。

現階段,火山引擎已經從底層基礎設施,到中間工具鏈、開發平臺,再到上層AI應用,以及最終的生態體系,搭建了全棧AI服務體系。AI大模型時代的來臨,給云廠商們提供了第二增長曲線,于火山引擎而言,則是其是否成為國內第四朵云的機會。

本文為澎湃號作者或機構在澎湃新聞上傳并發布,僅代表該作者或機構觀點,不代表澎湃新聞的觀點或立場,澎湃新聞僅提供信息發布平臺。申請澎湃號請用電腦訪問http://renzheng.thepaper.cn。

- 報料熱線: 021-962866

- 報料郵箱: news@thepaper.cn

互聯網新聞信息服務許可證:31120170006

增值電信業務經營許可證:滬B2-2017116

? 2014-2025 上海東方報業有限公司